Москва-Новосибирск, 26 апреля 2017 г. — В рамках ведомственной программы модернизации центров коллективного пользования Федерального агентства научных организаций (ФАНО России) были выделены целевые субсидии на комплексное обновление суперкомпьютерных центров в Центральном, Уральском, Сибирском, Дальневосточном, Северо-Западном и Приволжском федеральных округах. Одновременно в Москве и Новосибирске прошли официальные мероприятия, посвященные стратегической роли суперкомпьютерных вычислений в развитии российской науки в организациях ФАНО России. Они были приурочены к демонстрации результатов масштабного обновления вычислительных ресурсов Межведомственного суперкомпьютерного центра Российской академии наук (МСЦ РАН) и Центра коллективного пользования «Сибирский суперкомпьютерный центр» (ЦКП ССКЦ) Сибирского отделения (СО) РАН на базе Института вычислительной математики и математической геофизики (ИВМиМГ) СО РАН.

С приветствиями к собравшимся выступили руководитель ФАНО России Михаил Михайлович Котюков и Губернатор Новосибирской области Владимир Филиппович Городецкий. Для приглашенных гостей и журналистов была организована многосторонняя Интернет-видеотрансляция, соединившая Москву, Новосибирск, Екатеринбург, Иркутск, Владивосток и Хабаровск.

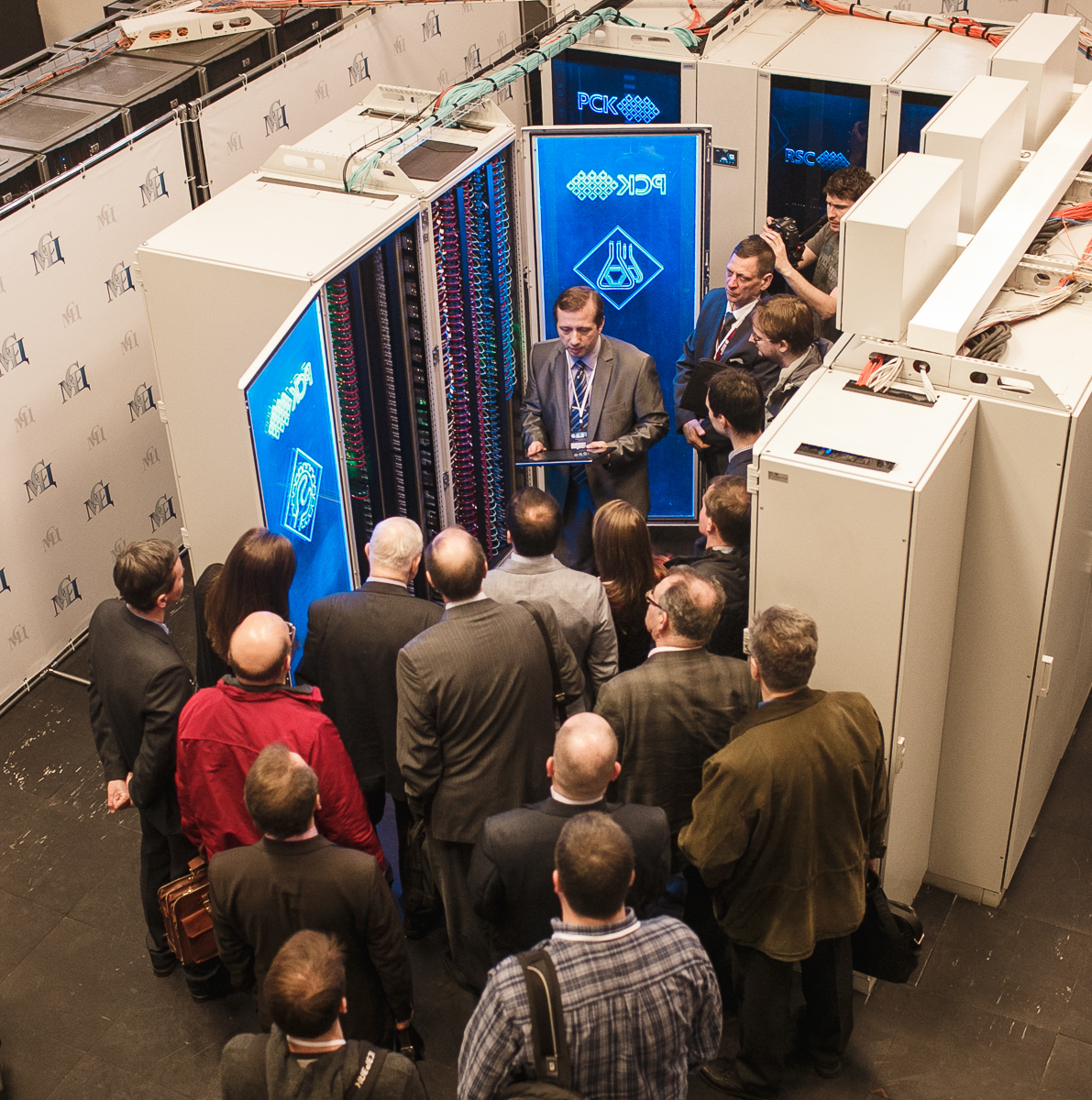

Оба проекта были реализованы группой компаний РСК, ведущим в России и СНГ разработчиком и интегратором высокоплотных решений для сегмента высокопроизводительных вычислений (HPC – high-performance computing) и центров обработки данных (ЦОД). В МСЦ РАН (Москва) и ЦКП ССКЦ СО РАН (Новосибирск) модернизированы суперкомпьютерные системы, общие ресурсы которых будут использоваться как основа территориального распределенного вычислительного комплекса для решения наиболее актуальных задач в области фундаментальных и прикладных наук, включая такие передовые направления исследований как искусственный интеллект (AI, Artificial Intelligence), машинное и глубокое обучение (ML/DL – Machine Learning, Deep Learning), работа с большими данными (Big Data) и другие. Суммарная пиковая производительность вычислительных комплексов в составе РАН и СО РАН теперь составляет около 1,1 ПФЛОПС (петафлопс - квадриллион операций с плавающей запятой в секунду, или 1000 терафлопс). Российские ученые из учреждений РАН в Москве и Новосибирске, а также из других регионов страны, смогут воспользоваться ресурсами не только одного, но и, при необходимости, сразу двух суперкомпьютерных центров одновременно, что позволит более эффективно и гибко предоставлять услуги Центров коллективного пользования.

Межведомственный суперкомпьютерный центр РАН является одним из самых мощных суперкомпьютерных центров коллективного пользования в России в сфере науки и образования. Коллектив МСЦ состоит из высококвалифицированных научных сотрудников, программистов и инженеров. Ресурсами Центра пользуются 184 группы исследователей, решающие задачи фундаментальной и прикладной направленности. В ходе модернизации суммарная пиковая производительность обновленного суперкомпьютерного парка МСЦ РАН, реализованного на базе вычислительных систем «РСК Торнадо» и RSC PetaStream с жидкостным охлаждением, выросла на 40%. В итоге общая производительность вычислительных ресурсов Межведомственного суперкомпьютерного центра РАН превысила 900 ТФЛОПС (терафлопс - триллион операций с плавающей запятой в секунду).

«Суперкомпьютерные технологии играют ключевую роль для перехода к передовым цифровым и интеллектуальным технологиям в информационном обществе. Модернизация вычислительных ресурсов МСЦ РАН позволяет нам обеспечивать новые возможности для проведения исследований и разработок, предоставлять исследовательским коллективам РАН мощные ресурсы для решения различных сложнейших научных и прикладных задач, а также обеспечить организацию наиболее эффективной работы российских ученых. Это позволит нам удовлетворять постоянно растущие потребности пользователей в повышении скорости обработки данных для высокотехнологичной медицины, повышения экологичности и эффективности энергетики, развития авиапромышленного комплекса и исследования динамики сложных космических систем. В результате модернизации пользователи центра смогут решать свои научные задачи на различных передовых архитектурах процессоров», – отметил академик РАН Геннадий Иванович Савин, научный руководитель Межведомственного суперкомпьютерного центра Российской академии наук.

В настоящее время услугами Центра коллективного пользования «Сибирский суперкомпьютерный центр» пользуются 24 института Сибирского отделения РАН (около 200 пользователей). После установки в марте 2017 года новой суперкомпьютерной кластерной системы НКС-1П на базе решения «РСК Торнадо» с жидкостным охлаждением общие вычислительные ресурсы ЦКП ССКЦ СО РАН были увеличены почти в два раза – на 71% до уровня 197 ТФЛОПС.

«Научные группы нашего института и других учреждений Сибирского отделения РАН смогут еще активнее использовать вычислительные ресурсы Центра коллективного пользования «Сибирский суперкомпьютерный центр» для выполнения актуальных исследований и большого количества численных экспериментов (суперкомпьютерного моделирования) в области газо-гидродинамики, физики плазмы, геофизики, квантовой химии, молекулярной динамики, загрязнения атмосферы, моделирования изменений климата и др. Особенно важно увеличение вычислительной мощности центра для нашего участия в Комплексном плане научных исследований «Алгоритмы и математическое обеспечение для вычислительных систем высокой производительности. Решение пилотных задач» и проекта ИВМиМГ СО РАН «Цифровая Арктика». С появлением нового современного вычислительного ресурса для Новосибирской области появляется реальная возможность перехода к «цифровой» промышленности и экономике в рамках концепции «Индустрия 4.0». Кроме того, текущее расширение вычислительной мощностей ЦКП ССКЦ СО РАН и возможность доступа к дополнительным ресурсам МСЦ РАН в рамках территориально распределенного комплекса позволит нам привлечь к процессам моделирования научных сотрудников из бывших медицинской и сельскохозяйственной академий», – подчеркнул Сергей Игоревич Кабанихин, директор Института вычислительной математики и математической геофизики Сибирского отделения РАН (член-корреспондент РАН, профессор, доктор физико-математический наук).

С технической точки зрения, оба проекта в суперкомпьютерных центрах РАН в Москве и СО РАН в Новосибирске уникальны тем, что это первое в мире внедрение серверных вычислительных узлов с жидкостным охлаждением в режиме «горячая вода» на базе самых мощных 72-ядерных процессоров Intel® Xeon Phi™ 7290 (были представлены в ноябре 2016 г.), а также на основе 16-ядерных процессоров Intel® Xeon® E5-2697А v4. Кроме того, в ходе реализации этих уникальных проектов впервые в России и СНГ коммуникационные подсистемы двух кластерных комплексов были реализованы на основе высокоскоростного межузлового соединения Intel® Omni-Path со скоростью передачи данных 100 ГБит/с.

Обновление вычислительного парка МСЦ РАН

В МСЦ РАН установлены новые универсальные вычислительные шкафы «РСК Торнадо» с рекордной энергетической плотностью и системой прецизионного жидкостного охлаждения, сбалансированной для постоянной работы с высокотемпературным хладоносителем (до +63 °С на входе в вычислительный шкаф). В соответствии с условиями размещения оборудования для МСЦ РАН был выбран оптимальный режим работы вычислительного шкафа при постоянной температуре хладоносителя +45 °С на входе в вычислительные узлы (с пиковым значением до +57 °С).

Работа в режиме «горячая вода» для данного решения позволила применить круглогодичный режим free cooling (24x7x365), используя только сухие градирни, работающие при температуре окружающего воздуха до +50 °С, а также полностью избавиться от фреонового контура и чиллеров. В результате среднегодовой показатель PUE системы, отражающий уровень эффективности использования электроэнергии, составляет менее чем 1,06. То есть на охлаждение расходуется менее 6% всего потребляемого электричества, что является выдающимся результатом для HPC-индустрии.

В основе новых вычислительных узлов: самые мощные 72-ядерные серверные процессоры Intel® Xeon Phi™ 7290, 16-ядерные серверные процессоры Intel® Xeon® E5-2697А v4, серверные платы семейств Intel® Server Board S7200AP и Intel® Server Board S2600KP, твердотельные накопители семейства Intel® SSD DC S3500 с подключением по шине SATA в форм-факторе M.2.

Для высокоскоростной передачи данных между вычислительными узлами в составе суперкомпьютерного комплекса МСЦ РАН теперь используется передовая технология высокоскоростной коммутации Intel® Omni-Path, обеспечивающая скорость неблокируемой коммутации до 100 Гбит/c, на основе 48-портовых коммутаторов Intel® Omni-Path Edge Switch 100 Series. Это позволит специалистам МСЦ РАН удовлетворить не только текущие потребности ресурсоемких приложений пользователей, но и обеспечить необходимый запас пропускной способности сети на будущее. Технология Intel® Omni-Path Architecture (Intel® OPA) представляет собой комплексное решение для высокоскоростной коммутации и передачи данных, призванное помочь с минимальными затратами повысить производительность работы приложений как в HPC-кластерах начального уровня, так и в масштабных суперкомпьютерных проектах. 48-портовый коммутатор Intel OPA позволяет при одинаковом бюджете подключать на 26% больше серверов по сравнению с конкурирующими решениями, а также снизить энергопотребление до 60%, обеспечивая, таким образом, более энергоэффективную коммутирующую и системную инфраструктуру.

Высокая доступность, отказоустойчивость и простота использования вычислительных систем, созданных на базе решений РСК для высокопроизводительных вычислений, также обеспечиваются благодаря передовой системе управления и мониторинга на базе ПО «РСК БазИС». Она позволяет осуществлять управление как отдельными узлами, так и всем решением в целом, включая инфраструктурные компоненты. Все элементы комплекса (вычислительные узлы, блоки питания, модули гидрорегулирования и др.) имеют встроенный модуль управления, что обеспечивает широкие возможности для детальной телеметрии и гибкого управления. Конструктив шкафа позволяет заменять вычислительные узлы, блоки питания и гидрорегулирования (при условии применения резервирования) в режиме горячей замены без прерывания работоспособности комплекса. Большинство компонентов системы (таких, как вычислительные узлы, блоки питания, сетевые и инфраструктурные компоненты и т.д.) представляет из себя программно-определяемые компоненты, позволяющие существенно упростить и ускорить как начальное развертывание, так и обслуживание, и последующую модернизацию системы. Жидкостное охлаждение всех компонентов обеспечивает длительный срок их службы.

Ранее специалисты группы компаний РСК разработали и установили в МСЦ РАН мощные вычислительные системы – суперкомпьютер МВС-10П МП (2014 г.) на основе массивно-параллельной архитектуры RSC PetaStream™ (это был первый проект в СНГ на базе высокопроизводительных сопроцессоров Intel® Xeon Phi™ 7120D) и суперкомпьютер МВС-10П на базе кластерной архитектуры «РСК Торнадо» (2012 г.). Кластерные системы МСЦ РАН входят в рейтинг Top50 самых мощных российских суперкомпьютеров, а также в мировые рейтинги Top500, Green500 и HPCG.

Новый вычислительный комплекс на базе «РСК Торнадо» в ССКЦ СО РАН

В основе вычислительных узлов в составе суперкомпьютера НКС-1П: самые мощные 72-ядерные серверные процессоры Intel® Xeon Phi™ 7290, 16-ядерные серверные процессоры Intel® Xeon® E5-2697А v4, серверные платы семейств Intel® Server Board S7200AP и Intel® Server Board S2600KP, твердотельные накопители семейства Intel® SSD DC S3500 с подключением по шине SATA в форм-факторе M.2.

Для высокоскоростной передачи данных между вычислительными узлами в составе нового суперкомпьютерного комплекса ССКЦ СО РАН также используется передовая технология высокоскоростной коммутации Intel® Omni-Path, обеспечивающая скорость неблокируемой коммутации до 100 Гбит/c, на основе 48-портовых коммутаторов Intel® Omni-Path Edge Switch 100 Series.

Кроме того, в рамках модернизации ресурсов ЦКП ССКЦ СО РАН, установлена новая система хранения данных (СХД) емкостью 200 терабайт (ТБ), реализованная на базе серверов «РСК Бриз» с параллельной файловой системой Lustre и ПО Intel® Enterprise Edition for Lustre.

Высокая доступность, отказоустойчивость и простота использования вычислительной системы обеспечиваются благодаря передовой системе управления и мониторинга на базе ПО «РСК БазИС».